基于 DolphinDB 打造面向 AI Agent 的数据底座

统一的多模态数据基座

DolphinDB 深度整合时序、向量与文本引擎,在同一个系统内实现海量业务数据与模型语义数据的统一存储,彻底解决多仓架构带来的数据割裂。依托领先的流批一体技术,开发者可使用同一套代码完成特征训练与实时推理,性能优化保证特征计算最低延时可达微秒级,为 AI 模型提供高性能的数据底座。

生成式 AI 与大模型生态

通过支持 MCP 协议,为大模型与数据资产的连接打造标准化桥梁,赋予大模型直接查数据、算指标、生成策略的专业执行力。结合原生向量检索与 Text-to-SQL 技术,企业能够快速构建高准确度的 RAG 方案与金融智能体,让大模型在理解复杂业务语义的同时,提供基于真实数据的专业决策支持。

机器学习模型推理加速

支持将机器学习推理过程直接下沉到数据层,无需跨系统迁移数据,即可在库内高效完成模型推理与复杂计算。DolphinDB 原生支持 PyTorch、TensorFlow、XGBoost、LightGBM 等主流框架模型,支持遗传规划、蒙特卡洛等算法,结合 GPU 并行加速能力,显著提升计算性能。

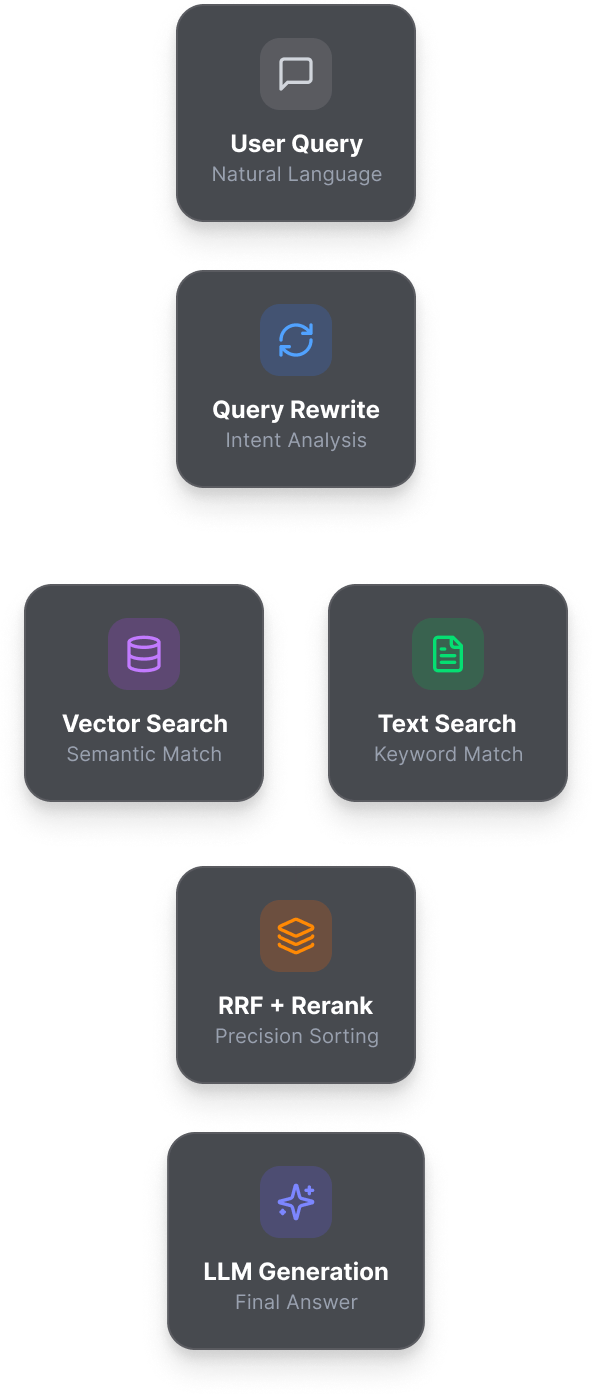

DolphinMind:企业级 RAG 智能体

DolphinMind 是基于 DolphinDB 强大的向量引擎、文本引擎和计算能力构建的企业级 RAG 智能体,旨在解答日常使用 DolphinDB 与 DLang 过程中遇到的各类问题。其采用“混合检索 + 多路召回 + 重排序”架构,深度整合数据库与大模型能力,确保专业问答的极速响应与逻辑精准,消除大模型幻觉。

快速响应,告别等待

依托 DolphinDB 的高性能向量与文本引擎,在海量知识库中实现瞬时检索,保障 AI 对话流畅响应。

语义 + 词法双重加持,精准溯源

采用“混合检索”架构,既能理解复杂的语义意图,也能精准锁定专业术语,确保每一个答案都“查有实据”,彻底消除 AI 幻觉。

深度意图理解,像专家一样思考

通过智能查询改写与多路召回技术,DolphinMind 能自动补全上下文,从多维度提取核心信息,给出逻辑严密的深度解答。

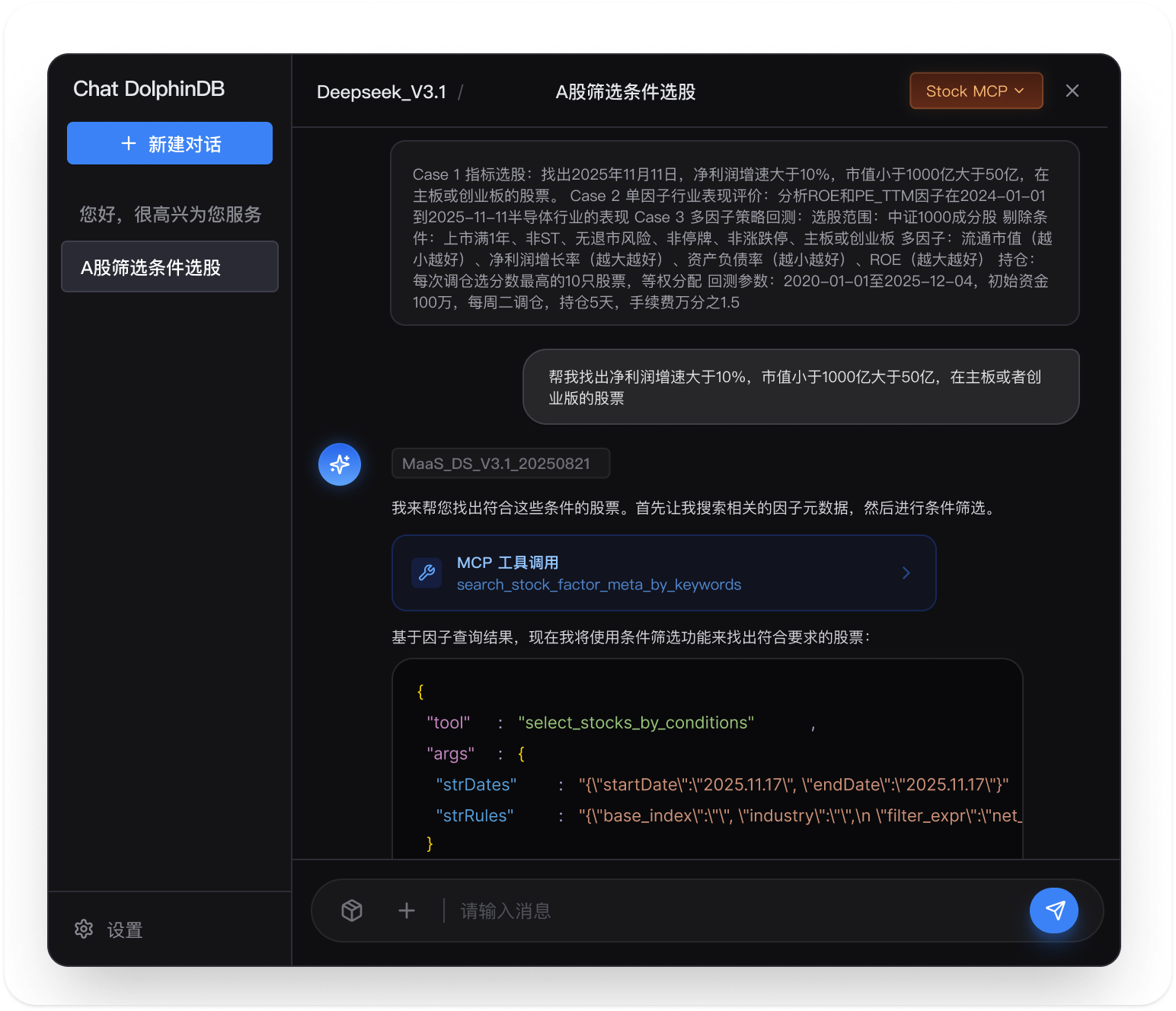

Starfish AI:金融级投研与因子开发智能体

Starfish AI 是基于 DolphinDB 构建的智能投研平台。它通过引入前沿 AI 技术,将传统的因子开发、策略生成与数据分析流程从“人工编写”升级为“智能驱动”,显著提升了金融机构在量化研究中的智能化水平与研究效率。

Starfish AI 通过自然语言交互,将研究员的逻辑构思高效转化为可执行脚本,大幅提升研究脚本的开发效率,实现了对海量历史数据的即时洞察。

因子与策略代码自动生成

根据用户对因子逻辑的文字描述,秒级生成计算脚本与完整策略代码,直接对接回测引擎。

统一数据层智能分析

通过自然语言提问,AI 自动检索全库表并编写分析脚本,快速返回大规模数据处理结果。

开发效率极致提升

大幅减少手动编写、调试代码的工作量,确保金融逻辑在底层高性能引擎上的准确运行。

AI 研报分析:打通从文献到因子的闭环

AI-Ready 的核心技术优势

向量与时序数据的一体化存储

DolphinDB 在原生时序引擎基础上集成向量与文本索引,实现了时序数据与语义向量的同库存储。这消除了跨库数据迁移的延迟,为 RAG 和多模态应用提供了统一存储与管理的数据基础。

微秒级“流批一体”因子工程

DolphinDB 支持使用同一套代码进行离线训练与在线推理。其内置的流计算引擎,既能对历史数据进行批量因子计算,也能对实时流数据进行毫秒级特征计算,两者逻辑一致,有效支撑模型从开发到上线的平滑过渡。

CPU-GPU 异构加速算力

针对 AI 训练与复杂模拟,用户可无缝切换 CPU 与 GPU 算力,利用 GPU 并行能力加速大规模因子挖掘,将原本数小时的计算任务缩短至分钟级。

丰富的实时流式触发机制

系统提供事件驱动、时间窗口等多种流式计算引擎,可基于规则实时触发特征计算,为对时效性要求较高的应用提供稳定的流式数据支持。

嵌入式深度学习推理引擎

通过 LibTorch 插件,DolphinDB 允许用户将训练好的模型直接部署在数据库内核。数据入库即推理,无需调用外部服务接口,从而在保证数据闭环的同时,实现了端到端“入库到预测”的极低延迟。

金融级分布式高可用架构

作为基础设施,DolphinDB 基于 Raft 协议提供强一致性保障与水平扩展能力。在支撑万亿级数据吞吐的同时,确保任务在节点故障时能无感切换,为核心 AI 业务提供金融级的稳定性与数据安全性。

AI 应用落地